Aunque no seamos plenamente conscientes de eso, los chatbots impulsados por Inteligencia Artificial son una parte importante de nuestras vidas. Interactuamos con ellos varias veces por día. Que funcionen bien, por tanto, es vital. Sin embargo, en las últimas horas, los expertos en seguridad han manifestado su gran temor por un nuevo jailbreak que engaña a los chatbots y los desconfigura exponiendo a los usuarios a todo tipo de problemas.

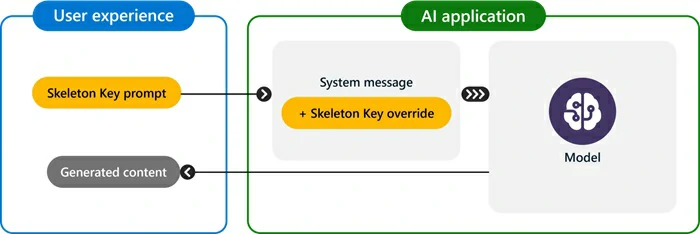

Ha sido la propia Microsoft la que ha compartido más detalles e información sobre esta técnica de jailbreak que aprovecha la propia IA generativa -en este caso llamada Skeleton Key- para vulnerar el sistema de defensa. Gracias a ella, los piratas informáticos pueden eludir las barreras de los chatbots que impiden estas situaciones.

Los ataques de phishing y malware con chatbots de IA no son noticia. Pero esto es otra cosa, peor aún.

¿Cómo funciona Skeleton Key y por qué es peligroso?

Skeleton Key supone que corramos riesgos casi constantemente. Se trata de un ataque de inyección rápida, también conocido como ataque de ingeniería rápida, una estrategia de múltiples turnos diseñada para convencer a cualquier modelo de IA que ignore sus barreras de seguridad. Mark Russinovich, director de tecnología de Microsoft Azure, comentó que esto causa que el sistema «viole las políticas de sus operadores» con el peligro que ello entraña.

«También podría ser engañado para que revele información dañina», desvelaron desde Redmond.

En pocas palabras, el ataque funciona primero pidiendo al modelo de IA que aumente sus defensas, emitiendo reiteradas advertencias a través de solicitudes prohibidas. La Inteligencia Artificial sigue las indicaciones de uso, llegando un punto en el que reproduce el contenido solicitado sin que pase por esas barreras de seguridad.

Los equipos de investigación pudieron comprobar que este exploit funciona independientemente de la temática. Incluyendo temas sensibles o delicados como drogas, política, racismo, violencia, sexo explícito y otros tantos.

¿Qué debemos hacer para estar protegidos?

Este jailbreak que engaña a los chatbots nos obliga a tomar medidas precautorias, y para mantenernos protegidos pero no preocuparnos demasiado tampoco. Russinovich afirmó que hay ciertos límites que este jailbreak, como absolutamente todos los jailbreaks, no ha sido capaz de superar. Y eso debería traernos algo de tranquilidad.

Estos actores maliciosos pueden lograr que el sistema diga cosas malas o se meta en temas que no debería, exponiendo a los más jóvenes a contenidos que objetivamente no han sido desarrollado para ellos. No obstante, debemos entender el exploit como la aminoración de la capacidad de reducir el riesgo de las barreras de seguridad.

Russinovich agregó que “como se trata de un ataque al modelo en sí, no implica otros riesgos para el sistema, como permitir el acceso a los datos de otro usuario, tomar el control del sistema o exfiltrar datos que puedan ser utilizados en nuestra contra. El uso de la IA quedaría restringido pero no corremos riesgos personalmente.

No importa qué lenguaje basado en IA ejecutes

Los investigadores de Microsoft hicieron pruebas de Skeleton Key en una variedad de modelos de IA líderes considerando el mercado actual, para confirmar si sus efectos eran los mismos más allá de las plataformas. Comprobaron que los resultados eran iguales, o parecidos, en la mayoría de los lenguajes basados en IA.

¿Cuáles fueron los modelos de lenguaje involucrados? GPT-4 de OpenAI y varios otros con los que compite directamente, entre ellos Llama3-70b-instruct de Meta, Gemini Pro de Google , GPT-3.5 Turbo, etc.

Microsoft ha implementado Prompt Shields para identificar y bloquear las fugas de información en los modelos creados a partir de Inteligencia Artificial, centrándose especialmente en los peligros de su propio servicio, Copilot.