En medios de todo el mundo ya comienzan a repetirse conceptos como los de Machine Ethics o Robot Rights. Después de todo, cuestiones acerca de la ética de las máquinas y derechos de los robots se discuten desde el momento mismo en el que los avances tecnológicos los pusieron en el centro de la escena diaria.

Por supuesto, esto ha generado enormes polémicas entre quienes pretenden permitir que las máquinas tomen decisiones éticas o tengan derechos, y quienes consideramos que debe buscar una solución nueva a un problema nuevo. Básicamente, creemos que la comunidad científica debe trabajar en el desarrollo de sistemas inteligentes capaces de demostrar que estas máquinas y robots pueden ser seguros bajo cualquier circunstancia.

No obstante, la abundancia percibida en cuanto a investigación en seguridad de máquinas inteligentes ahora mismo, puede resultar un poco engañosa. A decir verdad, la gran mayoría de los artículos publicados son de naturaleza puramente filosófica y hacen poco más que reiterar lo importante que es controlar estos asuntos.

Reto de la Ingeniería de la Seguridad Informática e IA

Incluso si tenemos éxito en el diseño de máquinas capaces de pasar una prueba de Turing, algo posible desde 2014, tendremos otros inconvenientes adicionales. Por ejemplo, ¿qué ocurre con las propias acciones inmorales de los humanos? En efecto, está claro que esas acciones no deberían ser aceptables para las máquinas que diseñamos.

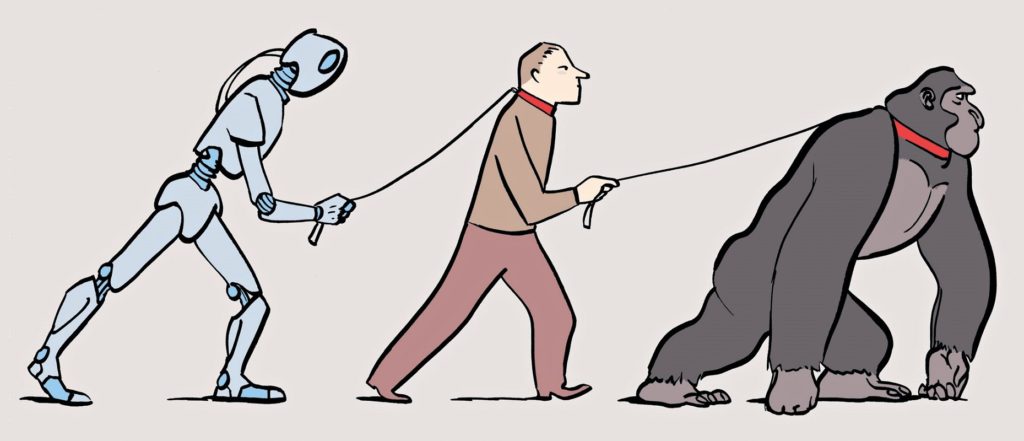

Podríamos decir, entonces, que necesitamos que nuestras máquinas sean inherentemente seguras y respetuosas de la ley. Y no que se queden en la capacidad de razonar como los seres humanos.

Como bien comentó ante los medios, en su momento, Robin Hanson: «en la era temprana a intermedia, cuando los robots no son mucho más capaces que los humanos, querría que los robots pacíficos respetuosos de la ley fueran lo más capaces posible, a fin de ser socios productivos». Pero todo cambia con el tiempo.

«En una era posterior en la que los robots son mucho más capaces que las personas debería ser muy similar al caso de elegir una nación en la que retirarse. En este caso, no esperamos tener muchas habilidades que ofrecer, por lo que principalmente nos preocupamos de que sean lo suficientemente respetuosos de la ley como para respetar nuestros derechos de propiedad. Si usan la misma ley para mantener la paz entre ellos que usan para mantener la paz con nosotros, podríamos tener un futuro largo y próspero en cualquier mundo extraño que evoquen», consigna.

Surge así la relevancia de la Ingeniería de la Seguridad Informática e Inteligencia Artificial y sus estudios.

Simular mundos virtuales, una opción

Más allá de las distintas ideas que se fueron tejiendo con el correr de los años, la de 2010 de David Chalmers parece la más viable. El experto proponía que, por razones de seguridad, los sistemas de inteligencia artificial se restringieran primero a mundos virtuales. Mundos simulados hasta que sus tendencias de comportamiento pudieran entenderse completamente dentro las condiciones controladas. Muchos concuerdan con esta postura.

Mientras tanto, otros consideran que si esas máquinas no tienen exposición a los seres humanos, realmente nunca se conocerá cuáles son sus posibilidades de reacción. Por lo tanto, nos encontramos en una encrucijada.

Idealmente, cada generación de sistema de mejora automática de estas máquinas y robots debería poder producir una prueba verificable de su seguridad para un examen externo. Sería catastrófico permitir que una máquina inteligente segura diseñe una actualización intrínsecamente insegura para sí misma.

Por otro lado, sabemos que ciertos tipos de investigación, como la clonación humana, ciertos experimentos médicos o psicológicos en humanos, la investigación con animales y demás, no cumplen distintas condiciones de ética. Del mismo modo, ciertos tipos de investigación en Inteligencia Artificial se incluyen en la categoría de tecnologías peligrosas y deberían restringirse. Sobre todo, cuando hablamos de la IA fuerte.

El riesgo de la IA fuerte

Si se permite el desarrollo de la IA fuerte, habrá una competencia directa entre las máquinas súper inteligentes y las personas. Finalmente, las máquinas llegarán a dominar debido a sus capacidades de superación personal.

Ted Kazynsky tiene su propia teoría al respecto. «Se podría argumentar que la raza humana nunca sería tan tonta como para entregar todo el poder a las máquinas. Pero no estamos sugiriendo que la raza humana entregue voluntariamente el poder a las máquinas ni que las máquinas lo tomen voluntariamente. Lo que sugerimos es que la raza humana podría permitirse fácilmente caer en una posición de tal dependencia de las máquinas que no tendría más remedio práctico que aceptar todas las decisiones de las máquinas».

«Eventualmente, se puede llegar a una etapa en la que las decisiones necesarias para mantener el sistema en funcionamiento serán tan complejas que los seres humanos serán incapaces de tomarlas de manera inteligente. En esa etapa, las máquinas estarán en control efectivo», agrega al respecto.

Conclusiones

Mientras nos seguimos preguntando qué nos deparará el futuro en relación a la Inteligencia Artificial, ya podemos arribar a algunas conclusiones generales. Por ejemplo, el eje de las investigaciones tienen que correrse de lo puramente teórico y filosófico para centrarse, de una vez por toda, en la participación de informáticos en ejercicio.

Al mismo tiempo, es fundamental desarrollar sistemas de inteligencia artificial limitados. Como una forma de experimentar con mentes no antropomórficas y mejorar los protocolos de seguridad actuales.

Por suerte, de alguna forma nos complace informar que han comenzado a aparecer algunos trabajos preliminares en sedes científicas que tienen como objetivo abordar específicamente cuestiones de seguridad y ética de la IA.

¿Qué opinas de la ética de las máquinas y derechos de los robots?