Siempre es bienvenido todo lo que sea para mejorar la seguridad infantil, por lo que estamos felices de conocer la nueva función que Apple ha incluido en la actualización iOS 18.2: Seguridad en la Comunicación que mejora su capacidad para filtrar contenido sexual e inapropiado sin sacrificar el cifrado de extremo a extremo.

Por el momento, únicamente está disponible en Australia, pero más adelante se ofrecerá a todo el mundo. La función utiliza aprendizaje automático desde los dispositivos para detectar imágenes y vídeos donde aparezcan desnudos, alertando y requiriendo ciertas acciones del usuario antes de poder visualizarlos.

Funcionamiento de la Seguridad en la Comunicación de Apple

La función usa inteligencia artificial en el dispositivo para comprobar las fotos y vídeos que se envían a través de las aplicaciones más utilizadas, como iMessage, AirDrop, FaceTime, y las apps de terceros como WhatsApp.

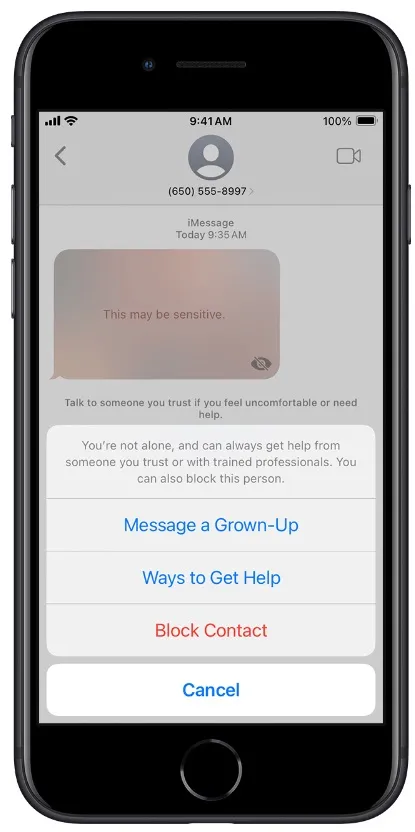

Esta comprobación, que preserva la privacidad de los datos al no enviarse a servidores externos, detecta y difumina automáticamente imágenes de desnudez, acompañándolas de advertencias sobre la sensibilidad del contenido.

Si el usuario menor de edad intenta acceder al material, debe confirmar su intención, o, si es menor de 13 años, no podrá visualizarlo sin que se ingrese un código de acceso desde el Control Parental de Screen Time.

Además, ofrece opciones para que el menor decida si abandonar el chat, bloquear al remitente o acceder a recursos online de seguridad infantil. También se incluyen mensajes de apoyo, recordando a la/el niña/o que es mejor evitar ver el contenido y que siempre puede obtener ayuda.

Tip: Evita que tu hija/o envíe fotos o vídeos sexuales en iPhone

Diferencias por edades y dispositivos

La aplicación de la función varía según la edad del usuario. Aquellos mayores de 13 años pueden optar por ver el contenido tras las advertencias, mientras que los menores de esa edad requieren intervención parental para poder acceder. Además, varía dependiendo del dispositivo:

- iPhone y iPad: incluye Mensajes, AirDrop, Contact Posters en Teléfono y Contactos, y mensajes de vídeo en FaceTime, además de algunas aplicaciones de terceros.

- Mac: escanea contenido en Mensajes y algunas apps externas si el usuario selecciona contenido para compartir.

- Apple Watch: aplica la seguridad en Mensajes, Contact Posters, y mensajes de FaceTime.

- Vision Pro: revisa el contenido en Mensajes, AirDrop y aplicaciones de terceros bajo los mismos criterios.

¿Cómo activar la seguridad infantil en iOS 18.2?

Como ya he comentado al principio, por el momento sólo está disponible en fase de pruebas en Australia, pero Apple planea lanzarlo a usuarios de otros países una vez finalicen dichas pruebas, y se podrá activar así: Configuración -> Tiempo de uso -> Seguridad de comunicación, obviamente desde iOS 18.

Además, Apple permite la opción de denunciar imágenes o vídeos inapropiados directamente desde el dispositivo móvil. En caso de enviar una denuncia, el sistema recopila la información de contacto de las cuentas implicadas, el material sensible, y mensajes enviados antes y después del contenido, lo cual se remite a Apple para su revisión. Después, Apple puede tomar ciertas medidas como avisar a las autoridades.

Recomendado: Aplicaciones de control parental

Complicaciones que tenía Apple para abordar el problema de contenido sexual e inapropiado en sus dispositivos

En 2021, la compañía intentó una solución basada en la revisión automática de imágenes en iCloud para detectar material de abuso infantil, conocida como CSAM (Material de Abuso Sexual Infantil).

La propuesta incluía la verificación de imágenes en busca de contenido ilegal y la posibilidad de enviar estos datos a revisores humanos. Pero el plan suscitó cierta polémica y preocupación entre defensores de la privacidad, quienes advertían que abrir esta puerta podía dejar a los usuarios vulnerables ante posibles abusos de vigilancia por parte de gobiernos y entidades externas.

Al final, ante las críticas, Apple decidió retirar esta función y trabajar en una solución menos invasiva, que ha terminado en el actual sistema de Seguridad en la Comunicación.